¿Que grados de libertad adicionales tiene el hablar de Multiversos sobre un Universo único?. En su momento (1924) Hubble descubrió otras galaxias externas a la Vía Láctea (Andrómeda), y nadie habló de Multiversos. Por tanto por qué no seguir hablando de un universo mucho mas amplio, con ciclos y partes que interaccionan finalmente unos con otros (o eso es al menos lo que predicen Penrose, Michio Kaku y Greene entre otros sobre las posibles trazas que esos otros universos pueden dejar en nuestra radiaciones de fondo! ¿entonces por qué empeñarse en hablar de Multiversos?

El Cosmos Antroscópico

El Cosmos a la escala del Hombre, y el Hombre como la medida del Cosmos

sábado, 3 de septiembre de 2011

Parallel, Cycles Multiverses vs. Universes

¿Que grados de libertad adicionales tiene el hablar de Multiversos sobre un Universo único?. En su momento (1924) Hubble descubrió otras galaxias externas a la Vía Láctea (Andrómeda), y nadie habló de Multiversos. Por tanto por qué no seguir hablando de un universo mucho mas amplio, con ciclos y partes que interaccionan finalmente unos con otros (o eso es al menos lo que predicen Penrose, Michio Kaku y Greene entre otros sobre las posibles trazas que esos otros universos pueden dejar en nuestra radiaciones de fondo! ¿entonces por qué empeñarse en hablar de Multiversos?

martes, 8 de febrero de 2011

PROPUESTAS DE NUEVOS LIMITES EN LOS AGUJEROS NEGROS por jg

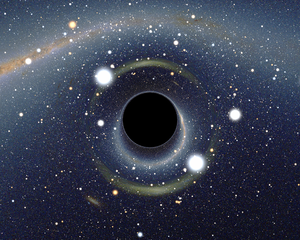

Imagen Cortesia wikipedia

Introducción. ¿Que se sabe de los AN?

Los Agujeros Negros (AN) son soluciones a las ecuaciones de Campo de la Teoría de la Relatividad General de Einstein caracterizados por una aglomeración tal de materia que, hace que se presente un "punto singular" donde la densidad y la curvatura espacio-tiempo se hacen infinitas. Esta singularidad se rodea de un "horizonte de sucesos", que extiende una especie de cortina denominada técnicamente "censura cósmica" para que el Observador exterior no pueda conocer lo que pasa en su interior, es decir las singularidades no se presentan nunca "desnudas". Este horizonte de sucesos se define como la superficie virtual a partir del cual ni siquiera la luz puede escapar del tremendo tirón del campo gravitatorio que hay "compactado" en su interior, y se determina por la conocida solución de Schwarzschild de agujeros negros (con simetría esférica, sin momento angular ni carga), cuyo Radio viene dado por:

(1) ; RS = 2*G*M/c2 ;

Donde "M" es la masa del AN, "G" es la constante Gravitacional y "c" la velocidad de la luz. Las leyes mecánicas de los AN (análogas a las leyes de la termodinámica) fueron propuestas por J. Bardeen, J. Bekenstein y S. Hawking, formulándose en términos geométricos su equivalencia. Así la primera ley de la termodinámica relativa a la Energía, la Masa se relaciona con la longitud (RS ) que equivale a su vez a la Energía; La segunda ley de la Termodinámica de la Entropía e Información se hace equivalente al Área del Horizonte sucesos; y la ley cero de la definición de la termodinámica relativa a la definición de la Temperatura, se relaciona a esta con la inversa de la longitud, lo que equivale a la Gravedad en la superficie del Horizonte de sucesos (demostrada por la Radiación de Hawking de los AN). Estas leyes termodinámicas de los AN se completan con la tercera ley de que no se puede alcanzar la temperatura del cero absoluto (un AN no puede tener una masa infinita!), de donde entresacaron el nuevo principio holográfico propuesto inicialmente por G. ´t Hooft y desarrollado ulteriormente en la Teoría de cuerdas por L. Susskind y Juan Maldacena, viniendo a afirmar que la información contenida en el volumen del espacio tridimensional- es codificada en las dos dimensiones correspondientes al horizonte de sucesos-, lo que confirma las equivalencias establecidas entre Información y el área del horizonte de sucesos. Existe además el teorema de los AN "Sin Pelo", postulado por W. Israel y B. Carter, en el que establecen que las soluciones de los AN se determinan con solo 3 parámetros (Masa, Carga Eléctrica y Momento Angular), es decir que los Agujeros Negros son indistinguibles unos de otros más allá de estos tres valores. Por ejemplo según este teorema, no somos capaces de distinguir los AN hechos de materia de los hechos de antimateria o de los hechos con materia oscura. Lo que nos lleva pensar que hay una gran cantidad de información que se pierde al caer la materia en los AN, y por tanto debe haber un gran incremento del desorden asociado al número de microestados posibles que son caracterizados por esos tres simples valores macroscópicos de masa, momento y carga eléctrica. Lo que puede deberse a la máxima activación (incremento) de los grados de libertad ocultos de la gravedad en los AN, según indica R. Penrose. El AN representa así, según J. Bekenstein el límite de entropía -desorden o aleatoriedad- máxima en la que una cantidad de información puede ser desordenada en un volumen dado. ¡Vamos que No hay forma de “revolver" más la materia dentro de ese volumen dado!).

Los AN los podemos identificar también como la confirmación de la flecha del tiempo, al hacer corresponder los aumentos de Entropía con los del tiempo (se supone que en el futuro el universo en equilibrio estará lleno de AN) y, con la irreversibilidad de los procesos (perdida del determinismo teorías clásica). Es interesante observar que en su libro del Gran Diseño S. Hawking define a los AN como las regiones del espacio-tiempo que, debido a su inmensa energía gravitatoria, quedan "desconectados" del resto del Universo. Y también la incoherencia que subyace de afirmar que las fuerzas gravitatorias no son determinantes a pequeñas escalas (frente a las nuclear fuerte, electromagnetismo y nuclear débil) porque las gravitatorias se expresan mejor en las grandes escalas como son las estrellas, galaxias, grupos, cúmulos, etc…Para luego afirmar que la singularidad del AN, las fuerzas que lo dominan son las Gravitatorias. ¿En qué quedamos?.

Imagen Cortesia wikipedia

Lo que nos conduce a un tema de "radiante" actualidad sobre si, los AN acaban perdiendo para siempre la información que entra en su interior, además de desordenarla de entrada. Debate conocido como la "paradoja de

Diagramas Conformes estrictos de Penrose para AN (Cortesia wikipedia)

¿Qué límites podemos postular sobre la estructura interna y la dinámica de acreción de los AN?

Volviendo a la ecuación 1, podemos ver que el Radio de Schwarzschild se puede deducir de una forma más sencilla (sin entrar en las ecuaciones de campo de Einstein ni en las métricas geométricas de Schwarzschild para resolverlas), al igualar simplemente el equivalente a una "energía cinética" de masa "m" (cualesquiera que sea el sentido del valor de la masa a la velocidad de la luz!) que trata de escapar a la velocidad "c" de la luz, de un campo gravitatorio creado por la Masa "M" del AN que tira de ella de ella para retenerla. Teoría clásica de Newton donde se igualan exactamente la Energía (positiva) Cinética con la Energía (negativa) Gravitatoria), o sea:

1/2*m*c2= G*M*m/RS ; Donde por suerte la masa "m" (infinita en términos relativísticos por ir a la velocidad de la luz) se nos anula exactamente en ambos miembros, por lo que nos queda felizmente la misma ecuación (1) de; RS = 2*G*M/c2

A partir de esta "nueva" formulación simple de los AN pretendemos proponer nuevos límites para las estructuras de los AN, al contestarnos a las siguientes preguntas:

I) La primera pregunta es, dado que la energía de una masa en reposo, es la conocida ecuación de Einstein: (2); E0 = m*c2 ;

¿A Qué distancia de la singularidad del AN estaremos cuando la partícula, habiendo atravesado el horizonte de sucesos se dirija hacia la singularidad, justo en el momento en que su energía en reposo E0 (que es la energía máxima de una partícula en reposo!) se iguale a la energía del campo gravitatorio. O sea:

E0 = m*c2 = G*M*m/R0 ;

Pues que nos da un nuevo Radio interno R0 = G*M/c2 ; y Dicho nuevo radio es exactamente igual a la mitad del radio de Schwarzschild (R0= RS/2).

Según esta conjetura, proponemos que a partir del R0 (la mitad del radio de Schwarzschild) tendríamos a un cuerpo con una energía superior a la dada por Einstein, lo que nos lleva a pensar que tendríamos problemas de inconsistencia (para un observador interno que pasara por ese radio interior al Horizonte de sucesos R0 ), y por tanto postulamos que existe otra superficie virtual interna al horizonte de sucesos, antes de llegar a la propia singularidad predicha por las EFE (Einstein Field Equations).

En resumen postulamos una nueva superficie virtual interna al AN, a la que denominaremos una capa más de cebolla del AN e internas al Horizonte de sucesos, para acomodar los diversos límites que se pueden ir transgrediendo, en este caso el de la equivalencia masa-energía antes de alcanzar la propia singularidad, la que se suponía era la única singularidad (infinita) que hay una vez tras pasado el horizonte de sucesos.

II) A partir del Radio de Schwarzschild RS = 2*G*M/c2 relativo a la superficie que delimita el horizonte de sucesos del AN, nos podemos preguntar además si existen otros limites de acreción de masas por unidad de tiempo (y que están por encima del flujo de masa de acreción dada por Eddington). Recordemos que el Límite de acreción de Eddington viene determinado en el equilibrio donde la la Presión de Radiación máxima iguala a la presión gravitatoria. Lo cual se asocia a una Luminosidad máxima (la de Eddington), deducible a partir de las ecuaciones de equilibrio hidrostático (gravedad) con la de la presión de radiación hacia fuera de electrones y protones (Temperatura o Luminosidad).

Pues bien este flujo de masa por unidad de tiempo de Eddington equivale a acretar del orden de 1018 gr./seg. Es decir, un flujo de una Masa solar por segundo que acretase un AN a través del disco de acreción, equivale exactamente a aprox. 1015 veces la Masas de Eddington (según se ve en el gráfico de Ramesh Narayan y su colega E.Q. que se muestra más abajo).

Por lo que cabe preguntarse (y nosotros nos lo hacemos) en ¿qué otro nuevo límite de flujo de acreción de masas aparecería (por encima del de Eddington) si definimos que dicha nuevo flujo de acreción de masa fuera tal que hiciera que el horizonte de sucesos del AN se moviese a la velocidad de la luz. Para obtenerlo, lo que hacemos es que la velocidad del horizonte de sucesos se mueva a la velocidad de la luz, lo que obtenemos derivando el Radio de Schwarzschild con respecto al tiempo, e igualando el resultado a la velocidad de la luz, así:

(3); dRS/dt = c;

Derivando con respecto al tiempo el otro miembro de la ecuación 1 del radio de Schwarzschild se tiene que:

(4); dRS/dt= 2*G/c2*dM/dt; donde aparece el flujo de Masas por unidad de tiempo y donde al igualar ambas expresiones (3) y (4) se llega a:

(dM/dt)0= c3/(2*G) , al cual denominaremos Flujo máximo de acreción de masa en AN de jg

(5); (dM/dt)0= equivale aprox. a 105 * MS ; o sea cien mil masas solares por segundo ¡.

Pensamos que esta nueva conjetura de que la velocidad del horizonte de sucesos en (expansión) no pueda superar la velocidad de la luz, se debe imponer para que los sucesos gravitatorios asociados al AN no interactúen con su entorno a una velocidad superior a la velocidad de la luz ¡. Otro fenómeno pronosticable es que el horizonte de sucesos supere antes la velocidad de la luz, correspondiente al medio del gas del disco de acreción, antes de alcanzar la velocidad del vacío, lo que pensamos provocará una onda de choque en el disco de acreción asociada al horizonte de sucesos del agujero negro, por analogía con las radiaciones Cherenkov de los rayos cósmicos en la atmosfera!.

En cualquier caso para que se dieran esas circunstancias habría que pensar en escenarios como la coalescencia de agujeros negros supermasivos o bien a los primeros instantes de formación del agujero negro central de una nueva galaxia, donde el AN dispusiera de un disco de acreción rico con abundantes estrellas jóvenes y masivas. Además pensamos que deberían producirse radiaciones muy por encima de los GRB (Gamma Ray Burst), dado que estos fenómenos se producen con acreciones de una masa solar por seg. de acuerdo al trabajo realizado sobre Black Hole Accretion por de Ramesh Narayan y de Eliot Quataert (ver http://astro.berkeley.edu/~eliot/science.pdf). Cuya gráfica se muestra a continuación, y en donde se observan los valores de una masa solar por segundo de acreción como potenciales causantes de los GRB.

En cambio nosotros estamos proponiendo, véase nuestra ecuación (5), acreciones del orden de 100,000 Masas solares por segundo para alcanzar estos límites de acreción de masa por unidad de tiempo que impliquen la expansión del horizonte de sucesos a la velocidad de la luz!. Lo que conjeturamos producirá fenómenos mucho mas energéticos que los observados GRB en el gráfico anterior (¿pudieran ser estas las causas buscadas de algunos de los grandes valores hallados para los rayos Cósmicos de mayor energía detectados de 1021 eV ó más?).

En cambio nosotros estamos proponiendo, véase nuestra ecuación (5), acreciones del orden de 100,000 Masas solares por segundo para alcanzar estos límites de acreción de masa por unidad de tiempo que impliquen la expansión del horizonte de sucesos a la velocidad de la luz!. Lo que conjeturamos producirá fenómenos mucho mas energéticos que los observados GRB en el gráfico anterior (¿pudieran ser estas las causas buscadas de algunos de los grandes valores hallados para los rayos Cósmicos de mayor energía detectados de 1021 eV ó más?).

Gráficos acreciones Eddington producen SNE y GRB Cortesia Ramesh Narayan y Eliot Quataert. Rs= Radio Solar.

Postulado que pasamos a denominar de ¡cuando la velocidad de la no información (del avance del Horizonte de sucesos) iguale a la velocidad de la información de la luz de la presencia del propio Horizonte de sucesos!. Otros autores como el Cosmólogo A. Alfonso-Faus, postulan que estas son precisamente las condiciones y descripciones que tiene nuestro Universo, considerado como El Agujero Negro por antonomasia, que explican y describen a este (ver el Universo como Agujero Negro de A. Alfonso-Faus en http://xurl.es/hfwfp).

III) Por ultimo podemos preguntarnos ¿si la estructura que tenemos de los AN, con su vacío “clásico” detrás del horizonte de sucesos hasta llegar a la singularidad central, es apropiada o no?. Pues lo que sabemos de la formación de horizonte de sucesos, es que implica que la masa que se encuentre en su interior se halle compactada por encima de unos determinados niveles de escala, que son a su vez funciones de la masa, como vamos a ver. Pues cualquier cuerpo o materia que se pueda compactar en un volumen inferior al del Horizonte de sucesos, quedaría velada o censurada para un Observador externo, al estar rellenando capas internas del AN con dimensiones finitas (y no como la imagen actual de un punto singular con valores infinitos de densidad y curvatura espacio-tiempo en el centro tal y como proponen las EFE). Para lo cual lo único que debemos exigirle es que, el grado de compacidad del objeto a “empaquetar” por debajo del Horizonte de sucesos del AN sea de cómo mínimo de la siguiente densidad. Calculada la densidad como el cociente entre la masa y el volumen que pondremos en función del Radio de Schwarzschild, así:

(6); ρ0 = 3/32*1/Π*C6/G3 *1/M2 ; lo cual equivale a aprox. a = 1083 gr3./cm3*1/M2…

Donde observamos que a medida que la masa es mayor, las exigencias de la densidad se van relajando en la proporción inversa al cuadrado de la masa. Así por ejemplo, para encontrar una densidad de compactación del orden de la del agua (1 gr./cm3) necesitaríamos meter a una masa del orden de 1000 millones de soles, como las que se dan en los Núcleos Activos de las Galaxias (AGN)¡ en un radio de apenas 10 Millones de Km ¡.

En resumen la idea de que no se conozcan actualmente fuerzas ni partículas, de acuerdo al modelo de la teoría estándar de la física de partículas para evitar el colapso de la materia desde la densidad de una estrella de neutrones que colapsa por acreción o como resultado de la explosión de una supernova SNE, hasta la singularidad del agujero negro, no significa que no se puedan conjeturar otros estados de condensación de materia/energía que lograsen retener el colapso de la materia (para evitar la singularidad puntual de los AN). Estas nueva materia compactada y estable podría proporcionar (de paso) valores finitos para los tamaños de la materia compactada en el AN, por debajo del Horizonte de sucesos y ello nos conducirá a una nueva física de partículas, donde se evitarían los tan temidos infinitos de las singularidades actuales!. No hay más que recordar que con el limitado rango de energías que se alcanzan con los Tera-Electrón-Voltio en los laboratorios terrestres como el LHC, se hace difícil conjeturar que hayamos hallado todas las partículas más elementales de la materia y de la fuerza (las que originan los campos). Pues sin lugar a dudas “aun nos queda mucho sitio al fondo” como indicaba irónicamente R. Feynman, al señalar que entre el tamaño de una partícula elemental del tipo electrón/proton (con un radio del orden de 10 -13cm) y la longitud de Planck (aprox. 10-33 cm) aun hay mucha distancia ahí abajo (20 ordenes de magnitud)!.

De Hecho, cabe esperar que existan otros estados de materia que lograsen que los objetos se puedan compactar al nivel descrito por la ecuación 6 (la del ρ0 ), como pudieran ser esas superficies postuladas anteriormente, donde la Energía de la masa se hace igual a m*c^2, lo que es igual a la energía del campo gravitatorio.

Imagen cortesia NASA

Conclusiones Conjeturas jg sobre AN

I) Se postula un radio interior, por debajo del Horizonte de sucesos de un AN, que denominamos R0, el cual es exactamente igual a la mitad del radio Schwarzschild, con RS = G*M/c2, a partir del cual se violaría, entendemos, el principio de la igualdad de la Energía de la masa equivalente en reposo de Einstein, lo que produciría una nueva superficie virtual interna.

R0= G*M/c2 ; es exactamente igual a la mitad del radio de Schwarzschild (R0= RS/2).

II) Se postula un límite máximo de acreción de masa por unidad de tiempo (o flujo másico) para un AN, muy por encima del valor límite de Luminosidad de Eddington, para el cual el propio horizonte de sucesos se expandiría a una velocidad igual a la de la luz. Lo cual entendemos significaría una forma de violar la velocidad máxima con la que el campo gravitacional interaccionaría con el resto del universo observable. Donde dicho flujo másico máximo de acreción viene dado por:

(dM/dt)0= c3/2*G ; lo que equivale aprox. a unas 105 * MS , donde Ms son Masas solares

El valor límite de Eddington pensamos que es superable, por el conjeturado por nosotros de cien mil masas solares por segundo, para el caso de que el AN acretase mas masa y energía de la que supone la Luminosidad máxima, por lo que es de esperar que se generen fenómenos asociados a energías mucho mayores que los GRB!

III) Se postula que los horizontes de sucesos no tienen porqué estar huecos en su interior hasta llegar a la singularidad, sino que pueden existir otros estados de la materia (quizás hechos de materia oscura u otra clase exótica!), que permitan que dicha materia sea compactada hasta determinados niveles muy elevados (pero finitos!) de densidad y curvatura espacio-tiempo, en el interior de los horizontes de sucesos pero no necesariamente ni singulares ni puntuales como predice la EFE. Candidatos posibles para ser compactados por debajo del horizonte de sucesos podrían ser condensados de nuevas partículas supersimétricas, componentes de los quarks, la materia oscura, etc. etc.

domingo, 24 de octubre de 2010

Conjetura de la métrica Antroscópica JG vs. el Universo Matemático

La Conjetura de la métrica del Universo Antroscópico, es decir nuestro Universo común centrado en los seres vivos, dista una distancia aprox. de 0,4343 de los Universos Matemáticos (Formales), dentro de los cuales está nuestro Universo Físico y Real.

Visualisation of the (countable) field of algebraic numbers in the complex plane. Colours indicate degree of the polynomial the number is a root of (red = linear, i.e. the rationals, green = quadratic, blue = cubic, yellow = quartic...). Points becomes smaller as the integer polynomial coefficients become larger. View shows integers 0,1 and 2 at bottom right, +i near top

Las ciencias han sido clásicamente divididas en ciencias Sociales, Naturales o Físicas y Formales. Las ciencias Sociales tratan de analizar al hombre y la sociedad, y su veracidad parece solo referida a los términos estadísticos de cuantos hombres mantengan una afirmación/opinión, así tenemos la Economía, la Sociología, el Derecho y es el lugar en el que anclaremos los fundamentos de nuestro Cosmos Antroscópico (el de las escalas del Hombre). Por contra las Ciencias Naturales tratan de los fenómenos de la Naturaleza, como son por ejemplo la Biología (estudio de los seres vivos), y en particular las Ciencias Naturales Físicas que buscan las leyes Universales del mundo inerte, como son la Física, la Química, la Astronomía cuya veracidad está fuera de toda opinión del hombre terrícola. Leer el libro de George Soros Sobre Crisis del Capitalismo Global, por su plástica diferenciación entre la verdad universal con independencias de cuantas personas piensen en ello y la verdad social ligada íntimamente a cuantas afirmaciones así se hagan.

Por último están las ciencias Formales, como la teoría de la Información, las matemáticas, que son descritas por R. Feynman como ciencias no físicas, puesto que no puede probarse nada sobre su realidad (si son verdaderas o falsas de acuerdo a alguna observación o experimento real, según el método de la Falsabilidad de K. Popper). Pues las matemáticas solo son ciertas, falsas o indemostrables (según el Teorema de incompletitud de K. Gödel), de acuerdo a la propia definición y reglas de las que se parte.

Por último están las ciencias Formales, como la teoría de la Información, las matemáticas, que son descritas por R. Feynman como ciencias no físicas, puesto que no puede probarse nada sobre su realidad (si son verdaderas o falsas de acuerdo a alguna observación o experimento real, según el método de la Falsabilidad de K. Popper). Pues las matemáticas solo son ciertas, falsas o indemostrables (según el Teorema de incompletitud de K. Gödel), de acuerdo a la propia definición y reglas de las que se parte.

En este sentido hay muchas críticas a si la Teoría de Cuerdas o la propia descripción de los primeros instantes de la teoría del Big Bang (a las que me sumo), son teorías físicas falsables o por el contrario, solo elementos especulativos matemáticos, que al adentrarse en las longitudes de Planck de 10^(-33) cm, tiempos de Planck de 10^(-43) seg., densidades de Planck 10^(-93) gr/cm^3 y temperaturas de Planck de 10^(32) ºK, no podrán ser nunca falsadas en un experimento que de realizarse, requeriría de aceleradores de partículas de tamaños y energías del orden del propio universo.

Volviendo al Universo formal de las matemáticas, ¿nos hemos planteado alguna vez como se pueden calcular las potencias de un número real elevado a otro, de una forma precisa?. Porque es obvio que sabemos multiplicar un numero por sí mismo un número entero de veces, Pero quizás tengamos muchas dudas de como multiplicar un número (a) por sí mismo "PI" veces, Donde ∏ es un número irracional (es decir que no se puede expresar como una fracción de números enteros n/m), y donde en este caso ∏ vale aprox.:

∏ aprox = 3,14159265358979323846...

Para saber como elevar "X" a Pi veces (se escribe X∏) conviene antes recordar que hay muchos procesos en la naturaleza cuya variación es proporcional a la variación "relativa" de otra cantidad, lo que se puede escribir así : ∆x = ∆y/y ; lo que genera el extraordinario número de funciones del tipo exponencial, que se expresa como y= aX + c . A la que probablemente estemos mucho más habituados con nuestra base decimal (a=10) ¿quién no sabe que 1000 se puede expresar como = 103 ?. Lo que quizás no nos sea tan cotidiano es saber que cuando ∆X y AY sean tan pequeños como se quiera (buscando el límite), se genera precisamente la definición de derivada, tal que: dy/dx= y; Lo que viene a decir que la derivada de la función que estamos buscando coincide con la misma función, tal y como se ve a continuación:

d (ex) / dx = ex

Cuya integración (proceso contrario a la diferenciación) genera los logaritmos Naturales o Neperianos (Ln), que reciben su nombre del matemático inglés del siglo XVI J. Napier. Es decir, que se cumple que Ln(y) = x , lo que se puede expresar en su forma exponencial natural de las matemáticas (base = e) como y= eX. Donde el valor del número trascendental "e" (que no puede expresarse como una raíz. o solución de una ecuación algebraica de polinomios), es aprox.:

e aprox. = 2,7182818284590452354

El número "e" fue descubierto por J. Bernoulli como límite "natural" de la ecuación del interés compuesto que los bancos deberían pagarnos si, en cada instante se incrementase el depósito inicial con el valor del interés anual (x), por contraposición a que nos paguen el interés a final del año. Donde eX se simboliza también como = exp(x), al ser el límite encontrado al añadir de forma continua (infinita) el interés ganado en cada instante al depósito acumulado, como encontró en su acepción más genérica el matemático suizo L. Euler, así:

Si se particulariza para x=1 se obtiene el número "e" que observo J. Bernoulli. A partir de aquí la definición de logaritmo natural (Ln) aparece al tomar como base "natural" de las potencias o exponenciales el número "e", así si se tiene un numero "Y" expresado en esa base como Y = eX entonces, tomando logaritmos neperianos en ambos lados de la ecuación, obtenemos: Ln (y) = x* Ln (e) = x . Cuyas características más notables son que p.e. la operación de multiplicar se transforma en sumar (en el plano de los logaritmos), y elevar a una potencia o exponenciar se convierte en multiplicar (en el plano de los logaritmos), así:

logb (x*y) = logb(x) + logb(y),

logb (xp) = p* logb(x),

De hecho a las "utilidades" antedicha del número "e", se le unen otras características muchas más profundas, como son las sintetizadas en la fórmula de Euler, para expresar los argumentos de los números complejos en su forma trigonométrica, de la que R. Feynman afirmó en su día que era una de las ecuaciones más notables de todas las provenientes del mundo de las matemáticas (donde "i" es el número imaginario):La cual de paso también permite generar los números complejos (números de dos dimensiones con una pareja de valores ordenada en parte real e imaginaria, tal que así (a; ib), que en el caso de Logaritmos de números negativos genera los número "i" y "pi, así":

Ln (-1) = i*∏

la cual genera una de las ecuaciones más bellas y elegantes del universo de las matemáticas, que es conocida como la Identidad de Euler, en la que en una sola ecuación se ligan los 5 números más importantes de las matemáticas: el vacio 0 y la unidad 1, el numero "i" que genera el campo de los números complejos (dos dimensiones), el número trascendental ∏ (relación entre el perímetro de una circunferencia y su diámetro); y el número "e" que es la base de las funciones exponenciales, Logaritmos naturales Ln y la potencia del cálculo de los números complejos (ecuación de Euler), además de las campanas de Gauss que tanta importancia tiene en Estadística y en las distribuciones de Maxwell-Boltzmann, Fermi-Dirac, Bose-Einstein para describir estados microscópicos de partículas. Así:

eiΠ + 1 = 0

La fuerza generatriz del número "e" proviniendo del Universo de las matemáticas, irrumpe en nuestro mundo social y "común", centrado en la cultura e intercambio de la información entre los "hombres terrícolas", a través de su base "común" de potencias como número "10", proveniente de que nuestros genes nos han dotado de 10 dedos (y no de 2,718281...). Lo que ha hecho que nos sea más fácil manejar y contar los números en base diez que en potencias de "e". Por lo que hemos introducido la base "10" para los logaritmos decimales (p.e. log (1000) = 3) ó de potencias (p.e. 103 =1000). Es decir, que nuestro mundo Antroscópico ha reemplazado la base natural "e" que nos proporciona un profundo sentido a todas las matemáticas y física, por la base artificial humana de "10", que acorde con el convenio social y cultural humano, nos ha situado finalmente a una cierta distancia de la base natural "e", a través del factor:

1/Ln(10) = 0,434294481903252...

Este factor que deseamos enfatizar bajo esta conjetura de la métrica Antroscópica, proviene de igualar un mismo número (Y), en estas bases diferentes (e; 10), con dos exponentes diferentes (X;Z) respectivamente, así:

Si eX = Y ; 10Z = Y;

Eliminando Y, los que nos lleva a que el exponente denotado por "z" referido a la base común "10", sea igual al exponente "x" en la base "e" de manera que z= 1/Ln(10)*x.

Métrica que denominaremos Antroscópica = 1/Ln(10) = 0,434294481903252...

Para entender mejor la escala logarítmica decimal y su entronque con nuestros genes, no tenemos más que fijarnos en las escalas artificiales que hemos ido inventado para medir los ruidos en decibelios (dado que se sabe el oído humano está diseñado genéticamente para captar las diferencia entre los cambios de los exponentes ó logaritmos y no en las cantidades absolutas de potencia de ruido). Así:

Donde W0 es el valor de referencia umbral de la escala de potencias.

El sentido humano sensorial más importante de la vista, originó en cambio la creación de la Escala decimal logarítmica de Pogson, para adecuar las definiciones de magnitudes de brillo con las realizadas por el Astrónomo Griego Hiparcos. Dado que el ojo, al igual que nuestro oído solo aprecia las variaciones en los valores de los exponentes ó cambios logarítmicos, y no los valores absolutos del flujo de brillo que nos llegan. Así:

El sentido humano sensorial más importante de la vista, originó en cambio la creación de la Escala decimal logarítmica de Pogson, para adecuar las definiciones de magnitudes de brillo con las realizadas por el Astrónomo Griego Hiparcos. Dado que el ojo, al igual que nuestro oído solo aprecia las variaciones en los valores de los exponentes ó cambios logarítmicos, y no los valores absolutos del flujo de brillo que nos llegan. Así:

Donde ahora F0 es un valor de referencia para el cálculo del Flujo de energía. Por tanto, del lado del Universo de las matemáticas parecería más conveniente haber definido en logaritmos neperianos o naturales las potencias de ruido y del flujo del brillo, y no en términos de los logaritmos decimales tal y como se ha hecho finalmente. Por lo que los mensajes de información que se envíen o puedan intercambiarse con otro tipo de inteligencia extrarrestres (como p.e. los que se desarrollen en el programa SETI), se deben codificar en un lenguaje universal matemático como es el número "e" o el "PI", que son los números naturales y universales sobre los que se basa en gran parte todo el andamiaje de las matemáticas. Puesto que nuestra base común del número 10 de aplicación exclusiva a los terrícolas humanos no posee ningún otro valor matemático, más allá del que pueda señalar el origen y evolución de nuestros genes.

Por tanto si no se puede cambiar esta forma de "conteo decimal humana" por su marcado peso social, cultural y genético, dejemos pues bien definido el cambio de escala de aprox. 0,4343 entre los exponentes del Universo Matemático y el Antroscópico, como parte de la que denominamos conjetura de métrica Antroscópica. Dejamos de paso abierto el análisis de si este número hallado, es trascendente o no.

Lo que si queda demostrado es que Ln (p) es un número trascendente siempre que sea valor entero (p.e. 10; ó 2 : ó 3, etc). Por el Teorema de Lindemann-Weierstrass. Lo que nos permite afirmar que cualquier forma de vida "exohumana" con un nmero entero de dedos o extremidades tiene un numéro trascendente matemático asociado

Lo que si queda demostrado es que Ln (p) es un número trascendente siempre que sea valor entero (p.e. 10; ó 2 : ó 3, etc). Por el Teorema de Lindemann-Weierstrass. Lo que nos permite afirmar que cualquier forma de vida "exohumana" con un nmero entero de dedos o extremidades tiene un numéro trascendente matemático asociado

jueves, 19 de agosto de 2010

El Mercado de la Cosmología : Datos, Medidas y Conocimiento

El libro del cosmólogo "heterodoxo" H. Ratcliffe titulado "The Static Universe: exploding the myth of cosmic expansion" publicado por Apeiron, Montreal 2010, ISBN: 978-0-9864926-2-4), me ha provocado la siguiente pregunta: ¿deberíamos tratar a la ciencia como a un mercado?, donde se oferten y "compren" tanto los datos (información), como los modelos de conocimiento, ahora que se cuida tanto que la información fluya a/de todos, a través de las redes sociales en Internet, como es este Blog.

Me explico, la propia comunidad científica (aunque muchos no lo reconozcan) etiqueta las ideas y conocimientos en normales o aceptables (lo que constituye el cuerpo de doctrina estándar y sino véase el Modelo Estándar de la Física de Partículas, o la Teoría del Big Bang -BBT-), y en cambio a otras ideas se las tacha de marginales o exóticas (aquellas que son menos "compradas") por parte de esta comunidad científica que se erige en dententadora de la "verdad científica". Estas Sociedades Científicas, han sido tildadas a su vez, de comunidades cerradas y elitistas frente a los nuevos valores de las sociedades abiertas e interactivas.

Pensándolo bien, no está mal que haya unas referencias, unos peritajes previos a cargo de los expertos, que ofrezcan unos valores normales de aceptación, en los que mirarse para la futura edificación de ese "mercado científico abierto" que propugnamos algunos. Pero el valor final tendrá que venir dado por el equilibrio entre la oferta y la demanda de toda la sociedad. Y subrayo toda porque al igual que funciona la democracia, la sociedad científica debe abrirse cada vez más y permitir que muchas de sus ideas sean también intercambiadas y debatidas por la sociedad libre en su conjunto. Creo que esta última característica encaja mucho con el esfuerzo y gran labor de divulgación que se viene haciendo desde la propia comunidad científica para acercar los nuevos descubrimientos científicos. Como señala el propio S. Hawking al final de su libro T.O.E. (Theory of Everything) "si descubrimos (la T.O.E), deberá ser comprensible en sus lineas generales por todos, no solo para unos pocos científicos. Para que todos podamos tomar parte en la discusión de por qué el Universo existe".Ver también (mas abajo en este blog) el vídeo de Lee Smolin "how Science is like democracy"

Pero volvamos al libro que hemos calificado de heterodoxo. Defender un Universo Estático frente al modelo "standard" del Big Bang, cuanto menos supone marginalidad para los autores que lo propongan y escasos recursos para el desarrollo de sus ideas (entendible en esta lógica de mercados). Así la BBT (Teoría del Big Bang que implica la expansión del universo y que hubo un principio) presenta una serie de fallas, que el autor desgrana en sus 240 páginas, y que aquí resumimos (sin ser exhaustivos) en los siguientes pros y contra argumentos:

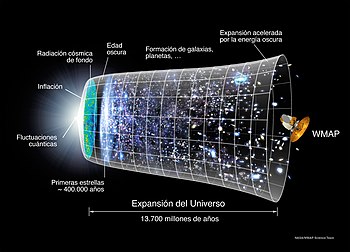

Según la teoría del Big Bang (modelo de Friedmann-Lemaître_Robertson_Walker), el Universo se originó en una singularidad espacio-temporal de densidad infinita. El Espacio se ha expandido desde entonces, por lo que los objetos astrofísicos se han alejados unos respecto de los otros.

Según la teoría del Big Bang (modelo de Friedmann-Lemaître_Robertson_Walker), el Universo se originó en una singularidad espacio-temporal de densidad infinita. El Espacio se ha expandido desde entonces, por lo que los objetos astrofísicos se han alejados unos respecto de los otros.

- los datos/medidas inicialmente realizados por E. Hubble (y publicados en 1929) mostraban un Redshift (corrimiento al rojo, definido por el parámetro z = v/c), mayor cuanto a más distancia se encontrase el objeto observado (generalmente cuasars), lo que le llevo a postular la ley de Hubble (de la proporcionalidad entre el corrimiento al rojo y la distancia). Este efecto Doppler (cambio relativo en la frecuencia/longitud de onda radiación), se puede interpretar bajo la hipótesis de la velocidad de la luz constante con el tiempo, como que el espacio se expansiona a una velocidad lineálmente dependiente (a través de la constante de Hubble de valor 71 km/sec/Mps) con la distancia. Idea central sobre la que se basa el BBT, y que causó incluso que el propio Einstein calificase como el "mayor error de su vida" el haber introducido (artificialmente) una constante cosmológica (lambda) para "obligar " en sus ecuaciones, a que el universo fuese estacionario en sus ecuaciones de campo de la TGR (Teoría General de la Relatividad). Constante Cosmológica que fue resucitada para la vida científica en los últimos decenios del siglo XX, para "ajustar" el efecto de la aceleración de la expansión (causada por esa energía oscura).

Pero este efecto (Redshift) puede ser debido también a otros factores, no aceptados hasta ahora como normales (se les suele denominar por la comunidad científica con apelativos de exóticos o no convencionales). Así, se ha sugerido que tal vez la velocidad de la luz disminuye con el tiempo. En este sentido cabe citar aquí los imaginativos trabajos del cosmólogo español A. Alfonso-Faus citados en el blog francistheemule.news Modelo Cosmológico Dr. Faus y los trabajos de Joao Magueijo sobre la variación de la velocidad de la luz con la inversa del tiempo. También el propio Zwicky echa mano de la la luz cansada (idea original de A. Einstein) como energía lumínica que disminuye por la interacción de la luz con los campos gravitacionales que encuentra en su camino hacia nosotros, y que podría explicar también el Redshift. Dichas hipótesis matemático-físicas son por tanto consistentes también con los datos y medidas realizadas, pero no implican para nada la expansión del universo.

Pero este efecto (Redshift) puede ser debido también a otros factores, no aceptados hasta ahora como normales (se les suele denominar por la comunidad científica con apelativos de exóticos o no convencionales). Así, se ha sugerido que tal vez la velocidad de la luz disminuye con el tiempo. En este sentido cabe citar aquí los imaginativos trabajos del cosmólogo español A. Alfonso-Faus citados en el blog francistheemule.news Modelo Cosmológico Dr. Faus y los trabajos de Joao Magueijo sobre la variación de la velocidad de la luz con la inversa del tiempo. También el propio Zwicky echa mano de la la luz cansada (idea original de A. Einstein) como energía lumínica que disminuye por la interacción de la luz con los campos gravitacionales que encuentra en su camino hacia nosotros, y que podría explicar también el Redshift. Dichas hipótesis matemático-físicas son por tanto consistentes también con los datos y medidas realizadas, pero no implican para nada la expansión del universo.

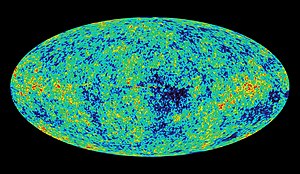

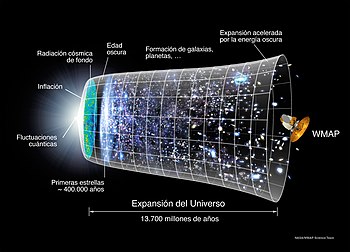

- Los datos medidos del CMBR (Cosmic Microwave Background Radiation) por los satélites COBE en 1989 (Cosmic Background Explorer) y mas recientemente en el 2001 por el WMAP (que proporciona un detalle más fino de la radiación), fueron inicialmente detectados en 1964 (accidentalmente) por A. Penzias y B. Wilson como el ruido de fondo de las antenas de telecomunicaciones que apuntaban a los satélites (y que por cierto les valió el premio Nobel). Esta radiación se corresponde con una temperatura del cuerpo negro de 2,725 ºK . Para la teoría del Big Bang esta temperatura se corresponde con el eco de ese fabuloso Big Bang, como se puede ver de la imágenes siguientes.

Pero también esta temperatura de fondo, puede haber sido causada por otros factores (y aquí entran de nuevo al escuela alternativa de los "heterodoxos"), como la temperatura de equilibrio del universo que tiene objetos dentro del mismo como estrellas, galaxias repartidas que están calientes (ver el trabajo de Paul Marmet & Others..). Y por qué no a la reciente propuesta (aún más audaz) realizada por el Dr. A. Alfonso-Faus sobre agujeros negros milimétricos de la masa de la luna, como explicación a la materia oscura y de paso como explicación del valor encontrado en la temperatura de fondo de 2,725 ºK del CMBR Explicación Masa Oscura Dr. Faus

Pero también esta temperatura de fondo, puede haber sido causada por otros factores (y aquí entran de nuevo al escuela alternativa de los "heterodoxos"), como la temperatura de equilibrio del universo que tiene objetos dentro del mismo como estrellas, galaxias repartidas que están calientes (ver el trabajo de Paul Marmet & Others..). Y por qué no a la reciente propuesta (aún más audaz) realizada por el Dr. A. Alfonso-Faus sobre agujeros negros milimétricos de la masa de la luna, como explicación a la materia oscura y de paso como explicación del valor encontrado en la temperatura de fondo de 2,725 ºK del CMBR Explicación Masa Oscura Dr. Faus

Imagen del WMAP del fondo cósmico de microondas

- Los datos de que los cuasares (muy lejanos por definición) siempre muestran los mas grandes corrimientos al rojo pueden quedar en entredicho, de acuerdo a los nuevos análisis de las imágenes que los relacionan con otros objetos (como galaxias) mucho mas cercanas (ver los trabajos sobre la Cruz de Einstein de Harton Arp). Lo cual vendría a indicar que el corrimiento al rojo no estaría ligado con la distancia y por ende con la velocidad de recesión, sino con otras características de los objetos cuasi estelares observados (QSO). En contra de los modelos "convencionales" que explican la Cruz de Einstein como efecto de las lentes gravitacionales, para permitir que estos QSO estén a mayor distancia.

- Pero aún hay mas, y es que las estructuras observadas (por su corrimiento la rojo) cerca de los momentos iniciales del Big Bang (13,700 millones de años), no serían compatibles con los miles de millones años necesarios para que se formasen las primeras estrellas, galaxias, etc. de acuerdo con autores como Lyndon Ashmore del Dubai College.

Si a estos datos/medidas, se le añade las "filigranas" que el modelo del Big Bang tiene que hacer para mantenerse en pie, se tienen las siguientes "extrañezas" (como ahora se pueden denominar a estas aberraciones por el lado de los heterodoxos):

- la Teoría de la inflación presupone una expansión exponencial en los primeros momentos del universo -modelo de A. Guth de 1981-, tal que nuestro universo pueda tener el tamaño mas o menos actual y permitir que en los primeros instantes la luz pudiese informar/interaccionar con todos los objetos (actualmente tan distantes), de manera que se pueda explicar porque vemos el Universo Homogéneo e Isótropo, pilares sobre los que sustentan las hipótesis del BBT. Estas propiedades se conocen como el Principio Cosmológico, bautizado así por E. Arthur Milne en 1933 (idea que al parecer también proviene de A.Einstein). Sin embargo, la magnitud y las fuerzas que desencadenaron (y pararon) esta inflación, siguen siendo desconocidas para resolver el denominado problema del horizonte, en lo que parece (para el punto de vista de los "heterodoxos") un recurso artificioso añadido al modelo BBT.

Esquema de la "inserción" de la T.Inflacionaria para adaptarse al universo conocido

Esquema de la "inserción" de la T.Inflacionaria para adaptarse al universo conocido

- un 73% de la energía es Oscura, es decir tiene origen desconocido, y se necesita en el modelo del BBT para explicar la reciente aceleración en la expansión del universo.

- un 23% de la materia presente es Oscura, es decir tiene origen desconocido al no haber sido detectada radiación alguna y pensarse que es de origen no bariónico, y se necesita para explicar el movimiento y energía cinética observado en otras estrellas y galaxias.

- La propia expansión del universo implica que el espacio que media entre nosotros se este abriendo continuamente), lo que dista mucho de ser algo comprensible y con sentido real, ademas de solo observable a escalas grandes y no a escala de nuestro grupo local.

- Las propias hipótesis de Isotropía y Homogeneidad, fundamentales para el modelo cosmogónico del BBT son puestas en entredicho por los datos procedentes del WMAP para acabar concluyendo que hay Anisotropía (se están midiendo variaciones de una parte en 100,000) por parte del satélite WMPA (Wilkinson Microwave Anisotrope Probe). Lo que según el BBT ayudaría a explicar la existencia de las singularidades de las estructuras que observamos como galaxias, estrellas, planetas. Es decir se contradicen los pilares del principio Cosmólogico (todo igual).

Sin el ánimo de insistir mas en las debilidades del modelo Estándar del Big Bang, lo que si parece prudente es adoptar una postura escéptica del BBT (que nos permita no negar los nuevos datos que se vienen midiendo), lo que por otro lado es claro que pone en riego la consistencia y viabilidad del modelo "Expansionista" BBT. En cambio pensamos, se debe mantener la mente más abierta a otros modelos, en la medida en que sean capaces de explicar mejor esas observaciones.

Esto devuelve a la reflexión al punto inicial, en el sentido de ¿qué pueden aportar otros modelos de conocimiento (llámese "no convencionales" u heterodoxos) al conocimiento Ortodoxo (el establecido convencionalmente por esa comunidad científica)?. Pues según nuestra postura, a que se tomen en cuenta seriamente sus observaciones y a que sean revisados los fundamentos de los modelos al uso. Me viene a la memoria, que el defensor del modelo del Universo Estacionario Sir Fred Hoyle, que además fue quien bautizo al modelo expansionista de forma peyorativa como el del "Big Bang" en un programa de radio en 1950, fue un científico reputado que hizo aportaciones muy valiosas al desarrollo del modelo de nucleosíntesis de las estrellas (los procesos que se desarrollan en el interior de las estrellas que sirven para generar los elementos químicos más pesados como el O, C, Si, a partir del H y He, ideas cuya validez es aceptada independientemente.

Finalmente, me quedo a modo de conclusión con las palabras del Dr. Martín López-Corredoira del IAC, en el sentido de que los datos actuales (refiriéndose a la Anisotropía medida por el CMBR del WMAP) y su caracterización paramétrica frente a las variables de los modelos científicos (ya sea el Big Bang u otros) dista mucho de ser un sistema de ecuaciones (datos vs. incógnitas) compatible y determinístico. Esto es, tenemos por un lado muchos datos que no compatibles con los modelos, y muchos otros datos que pueden ser caracterizados (paramétricamente) de diversas formas, de manera que mediante "ingeniería estadística" pueden ser ajustados para soportar varios modelos de conocimiento al mismo tiempo. Como López-Corredoira afirma, esto se produce "habida cuenta de que el número de parámetros independientes en los datos (información) es del mismo orden que el de parámetros libres (incógnitas) a ajustar de los modelos (conocimiento)"

Llegados a este punto me pregunto si la validez estadística de este mercado de datos y conocimiento Cosmológico que propugnamos, no residirá en una suerte de nuevo Principio de Incertidumbre Cosmológico (a descubrir al nivel de las escalas macroscópicas del Universo), por simetría con el de las escalas Microscópicas de Planck, que hace que la naturaleza de la realidad "macroscópica" se vuelva probabilítica, incierta y dependiente del observador (como escala Antroscópica del Hombre), que es él único que la hace posible "colapsar" en un valor concreto, a través de la medida.

Como tributo al Astrofísico Heterodoxo "Think Tank" que es Hilton Ratcliffe, y dado que no disponemos de ningún vídeo de su actividad cosmológica, incluyo aquí sus pensamientos (también calificables de heterodoxos) sobre el Calentamiento global. En el que carga esta vez, contra el modelo standard del AGW (Anthropogenic Global Warming), basado, según él, en las falsas tesis científicas incluidas en la propuesta de Al Gore. Al sostener que los datos actuales (e históricos) sobre la Meteorología y los modelos de conocimiento (meteorológicos) no son determinantes actualmente ni para afirmar que hay calentamiento global (efecto), ni que su causa se deba a la actividad del hombre. Esto no quita que él y muchos de nosotros, seamos defensores de la sostenibilidad energética y preservación del medio ambiente, pero por otras razones.

domingo, 6 de junio de 2010

La Paradoja JG : un universo lleno de vida pero sin posibilidad de interacción

La paradoja de JuanGerardo (JG) se puede enunciar así: el aislamiento ó imposibilidad de interacción con otra vida inteligente dentro de nuestro Universo, aunque el propio Universo puede estar lleno de vida inteligente.

- Para ello, si se se admite que la vida inteligente (como la humana) requiere de 2/3 del tiempo desde el BigBang: Suscintamente 1/3 del tiempo se consume en generar estrellas de segunda generación como el Sol con elementos pesados, y el otro tercio para generar la vida humana (tal como la conocemos con capacidad de transmisión de radio, que lleva hace solo 100 años desde la formación del Sol), con lo que apenas nos puede quedar, en el mejor de los casos, otros mil/dos mil millones de años antes de que la tierra sea inhabitable por la expansión del sol convertido en una gigante roja...y por tanto ese es el tiempo límite que hay finalmente para entrar en contacto/interacción con otra vida inteligente.

- Pero podemos suponer que la aparición de una vida inteligente (no microscópica como la que había en la tierra hace 3,500 millones de años) sino como la nuestra o superior, es un fenómeno posible pero altamente improbable, por ejemplo del orden de una vez por galaxia. Y sabiendo que el universo tiene del orden de 10^11 galaxias, resulta que puede haber la fantástica cifra de 100,000 millones de vidas inteligentes en nuestro Universo. Es decir, que estaría lleno de vida inteligente. Pero si la consideramos distribuida uniformemente en el volumen (isotropicamente y homogeneamente), determinado por el radio del universo, que se obtiene como la distancia viajada por la luz en sus 13,700 millones de años, pues resulta que el Camino Libre Medio, para encontrar esa tal vida es del orden de miles o decenas de miles de millones de años, lo que nos vuelve a dejar incomunicados, aislados y fuera de toda posible interacción con otra vida inteligente, de por vida.

- El Camino Libre Medio, para interactuar o encontrar otra galaxias con vida, se obtiene como la inversa de la densidad de vida (galaxias con vida, del orden de 10^11, dentro del volumen total del universo del orden de 10^84 cm^3 ) e inversamente proporcional también a la sección eficaz de una galaxia, determinada por un área de un diámetro característico como, por ejemplo el nuestro de la vía láctea del orden de10^46 cm^2. de lo que resulta finalmente un valor del orden de varios miles de millones de años de distancia para poder dar con otra vida inteligente, de lo que se desprende del primer párrafo que las posibilidades de interacción, con esa otra vida inteligente son practicamente nulas o inexistentes.

- La pregunta Cosmológica que entonces surge de forma natural es, ¿que sentido tendria todo este derroche de vida en el Universo, sin que podamos verificarla ni compartirla como una sola inteligencia?

sábado, 8 de mayo de 2010

lunes, 3 de mayo de 2010

Suscribirse a:

Entradas (Atom)